Itzulpengintza automatikoaren historia

Itzulpen automatikoaren inguruko ikerketak 1930 eta 1940ko hamarkada bitartean hasi ziren.

Hasierako ikerketak[aldatu | aldatu iturburu kodea]

Lehendabiziko aurrerapen informatiko aipagarriak ENIAC ordenagailu ospetsuan egin ziren 1946an. Ikerlari aitzindarien artean Warren Weaver, Rockefeller Fundaziokoa, aipatu beharra dago. Bera izan zen diziplinaren berri eman zuena izan zitezkeen diziplina hori aplikatzeko metodo zientifikoak aurreratuz: teknika kriptografikoen erabilera, Shannonen teoremen aplikapena eta estatistikaren erabilgarritasuna, baita gizakion hizkuntzaren azpiko logika eta antza dituen ezaugarri unibertsalez profitatzeko aukera ere. Munduan gerra bat amaitzen ari zen, orduan maila zientifikoan mezu ezkutuak argitzeko metodo konputazionalen garapena sustatu zuen mundu gerra. Weaverrek esan omen zuen "errusieraz idatzitako artikulu bat ikusten dudanean neure buruari esaten diot, hori ingelesez idatzita dagoela, baina ikur berezien bidez kodeturik. Dekodetu dezagun oraintxe bertan!" (Barr eta Feigenbaum-ek aipatua, 1981). Zeresanik ez dago orduan oso arruntak zirela ordenagailuak eta programatzeko teknikak (tableroen kable multzoaren bidez makina lengoaian programatzen zen), eta hori zela kausa metodoak frogatzeko aukera errealak oso gutxi ziren.

Ikerketen aurrerapenak[aldatu | aldatu iturburu kodea]

1951n Massachusetts-eko Teknologia Institutuak (MIT) bere adituetako bati, Yehoshua Bar-Hillel, soilik IAan aritzeko dedikazio esklusiboa eman zion. Urtebete geroago IAren lehenengo sinposioa antolatu zen hizkera kontrolatuak, azpi-hizketak, sintaxiaren beharra, edo gizakion esku hartzerik gabe aritzeko aukera bezalako gaiekin. Itzultzaile automatiko baten lehendabiziko agerpen publikoa 1954an izan zen Georgetown Unibertsitatean, IBMren laguntza eta Leon Dostert ikerlariaren parte hartzearekin. Kontu handiz errusieraz zeuden 48 perpausa aukeratu eta ingelesera itzuli 250 hitzetako hiztegia eta 6 erregela gramatikalen bidez. Erakustaldiaren arrakasta baldintzatua nabarmena izan zen eta AEBetan aurrekontuen partida garrantzitsuak (gehienak Defentsa Ministerioak emanda) egon ziren errusiera, frantses eta alemanetik itzulpenak egiteko. Hasierako euforia unea izan zen "kalitate altuko itzulpen guztiz automatikoa" (Fully Automatic High Quality Translation, FAHQT) delakoaren helburua planteatzea eragin zuena. Hamarkada hartako garapen aitzindarien artean Georgetown eta Texas unibertsitateetakoak azpimarratu behar da, bertan egun oraindik diren sistema biren oinarriak ezarri ziren, "SYSTRAN" eta "METAL" hurrenez hurren.

ALPAC txostena[aldatu | aldatu iturburu kodea]

Hala eta guztiz ere, hasierako inbertsio handi haiek ez zuten espero zen emaitza ematen. Bar-Hillel-ek 1960an FAHQT-aren ideia zalantzatan jartzen ausartu zen esanez, gizakiak eginiko itzulpenetan lortutako emaitzekin alderatu ahal izateko oraindik ezin lor daitezkeen ezagutza semantiko eta pragmatikoa gehitu beharra legokeela, hortaz, helburu gutxiago izateko aholkua eman zuen. 1964an "National Research Council-ak" ALPAC izeneko komitea eratu zuen ("Automatic Language Processing Advisory Committee") IAren egoera baloratzeko. Bi urte beranduago ALPAC txostenean argitaratu ziren emaitzek ondorio larriak izan zituzten: "…ez da itzulpen automatikorik lortu testu zientifiko orokorretarako, eta ez dirudi epe laburrean lortuko denik". Emaitzak diru iturrien mozketa ikaragarri batean amaitu zuen, literalki AEBetako ikerketekin bukatu zuena. Edozelan ere, teoria mailan aurrerapen handiak izan ziren garaia izan zen. Noan Chomsky-k hizkuntzen azterketan iraultza sortu zuen "Syntactic Structures" bere lana argitaratzean 1957an. Informatikari dagokionez, maila altuko programazio datu eta hizketa egituren diseinu berriek (ALGOL, LISP) algoritmo eta modulu metodologien garapena ekarri zuten, diziplinaren bilakaeran funtsezkoak izan zirenak hain zuzen.

1970-1980ko hamarkadak[aldatu | aldatu iturburu kodea]

ALPAC txostenak erabat kaltetu zuen IA AEBetan, baina Kanada eta Europan ez zuen apenas eraginik izan. 1976an TAUM taldeko ikerlariek ("Traduction Automatique de l'Université de Montréal") "MÉTÉO" sistema aurkeztu zuten, metereologi parteak ingelesetik frantsesera itzultzen zituena. Historia egin duen sistema da aplikapena eta diseinuaren egokitasunagatik. Urte hartan bertan EB-k IAra jotzea erabaki zuen administrazio egoitza ezberdinetan zuten itzulpen eskaeren hazkunde itzelari aurre egiteko asmoz. Komisioak SYSTRAN garatu eta zituzten beharretara egokitzeko lizentziak erosi zituen. Geroxeago, Europan ikerketa sustatu eta itzulpenen kalitatea hobetzeko ideiarekin, Komisioak berak "EUROTRA" proiektu handizalea finantzatu zuen. Laurogeiko hamarkada osoa hartu zuen garai hura metodo sinbolikoen garapena eta sintaxi (ezaugarriak bateratzean oinarrituriko gramatikak) eta semantika mailako (predikatuen logikan oinarrituriko formalismoa) ikerketaren bizitasun handia izan zuen ezaugarri nagusi. Halere, teoria mailan eginiko aurrerapenak ez ziren emaitzetara ailegatzen.

1990eko hamarkada[aldatu | aldatu iturburu kodea]

Dudarik gabe 1991n EB-k agindu zuen Danzin txostenaren emaitzekin lotuta, Europan IArekin zerikusia zuten berri txar bi egon ziren. Instituzioei dagokionez, EB-k EUROTRArako finantzazioa bertan behera uztea erabaki zuen; enpresen aldetik, PHILIPS-ek ustekabean amaitutzat eman zuen adituen artean prestigiorik gehien zuen proiektuetako bat, "ROSETTA". Une horretan bertan Japonen aurreko urteetako inbertsio onen ostean aurrekontuen politika zuhurrago bat aplikatu zen. Beherakada orokorraren Testuinguru horretan itzulpen lagunduaren produktu mota bat azaldu zen merkatura, aurrekoen oso bestelako diseinua zuena. Itzulpen memorien kudeaketa programak ziren, hasiera batean IBM-k ("Translation Manager") eman zuen ezagutzera eta geroago publikora atera zituzten alemaniako TRADOS enpresek ("Translator´s Workbench") eta STAR ("TRANSIT"), eta Espainiako ATRIL ("DÉJÀ-VU"). Azpimarra daitekeen garai hartako beste alderdi bat Internet-aren garapena da itzulpenaren ikuspegitik lokalizatzearen ikuspegirako aldaketarekin batera.

2000ko hamarkada[aldatu | aldatu iturburu kodea]

Gaur egun etapa berri baten hasieran gaude. Enpresa eta merkatuen globalizazioarekin batera produktuek eta zerbitzuek "tokian tokiko" egokitzapena izatea dator. Iraganaren jazarle, teknologia asko arkitektura hibridoetan sartzen eta osatzen ari dira, itzulpena orain benetan elektronikoa den informazioaren ziklo konplexuaren beste maila bat bailitzan ulertzen dute. Garapen hauen guztien leitmotiv deiturikoa Internet da oraindik ezin aurrera ditzakegun inplikazioekin, baina neurri handi batean jabego intelektuala eta pilatzen ari diren hizkuntza baliabide ustiaketaren eskubideak argituko diren moduaren menpe daudenak.

2010eko hamarkada[aldatu | aldatu iturburu kodea]

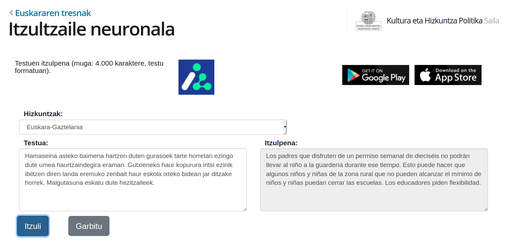

Paradigma neuronalaren ekarriarekin 2017z geroztik izugarrizko hobekuntza nabaritu zen hizkuntza nagusienen arteko itzultzaile automatikoetan. Geroxeago, eta arin, euskal munduko ikerkuntza komunitatea gai izan zen euskaratik eta euskararako itzultzaile neuronalak mundu mailako artearen egoeraren pare jartzeko.

2015ean hasi zen euskararako itzulpen neuronala aztertzen TADEEP proiektuan.[1] Orurako Deepl itzultzaileak kalitatezko emaitzak ematen zituen 10 hizkuntzatan baina euskara ez zegoen horien artean. Bi urte geroago lehenengo emaitza bikainak lortuta, 2017an lehen demoa publikoki eskura zegoen. 2017an bertan, hainbat agente (Ixa Taldea, Elhuyar, Vicomtech, Ametzagaña, Mondragon Lingua...) batera, MODELA izeneko proiektua abiatu zen.[2] Beste urtebeteko epean, 2018an MODELA itzultzailea plazaratu zen, Interneten publiko orokorrerako euskarazko itzulpen neuronala eskaintzen zuen lehen zerbitzua.

Abiada bizian mugitzen zen arlo honetan, geroago gutxienez beste hiru itzultzaile neuronal gehiago plazaratu ziren. Horien arteko diferentzia nagusia itzultzaile bakoitzak erabiltzen duen corpusa da (corpus = milioika esaldi bi hizkuntzatan), baita itzultzeko zerbitzuan onartzen duten hitz-kopuru maximoa ere (konputagailu ahaltsu eta garestiak erabili behar dira horretan). Hauek ziren 2020ko hasieran eskaintzen ziren euskararako itzultzaile neuronalak:

- Eusko Jaurlaritzaren Itzultzaile neuronala: itzulpen neuronalaren teknologia erabilita, corpus-oinarria Eusko Jaurlaritzako itzulpen-memoriak erabili ziren IVAP-HAEEk 20 urtetan bildutakoa 10 milioi "esaldi" baino gehiago..[3]

- batua.eus: Vicomtech-ek MODELA sisteman hobekuntzak egin zituzten (RNN teknologiatik Transformer teknologiara pasa ziren) eta corpusa handitu zuten.[4][5]

- Itzultzailea.eus: Elhuyarrek ere antzeko hobekuntzak egin zituen bere aldetik. Eta itzulpenak egiteko hizkuntza berriak gehitu zituen (ingelesa, frantsesa, espainiera, galegoa, eta katalana)[6]

- Translate Google: Googleren Translate zerbitzuak hobekuntzak lortu zituen eredu neuronala erabilita.[7]

-

Jaurlaritzaren itzutzaile neuronala

-

Batua.eus

-

Elhuyarreko itzutzailea.eus

Erreferentziak[aldatu | aldatu iturburu kodea]

- ↑ «Welcome to TAdeep (MINECO-FEDER project) | TAdeep» ixa2.si.ehu.es (Noiz kontsultatua: 2020-01-28).

- ↑ «MODELA» modela.ametza.com (Noiz kontsultatua: 2020-01-28).

- ↑ Eusko Jaurlaritza. (2019). «Euskara-Gaztelania itzultzaile automatiko neuronala» www.euskadi.eus (Noiz kontsultatua: 2020-01-28).

- ↑ «BATUA.eus - Euskarazko itzultzailea» www.batua.eus (Noiz kontsultatua: 2020-01-28).

- ↑ Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia. (2017). Guyon, I. ed. «Attention is All you Need» Advances in Neural Information Processing Systems 30 (Curran Associates, Inc.): 5998–6008. (Noiz kontsultatua: 2020-01-28).

- ↑ «Itzultzailea» Itzultzailea (Noiz kontsultatua: 2020-01-28).

- ↑ «Google Translate» translate.google.com (Noiz kontsultatua: 2020-01-28).

Ikus, gainera[aldatu | aldatu iturburu kodea]

- Itzulpen automatiko neuronal.

- Itzulpengintza automatiko

- Adibideetan oinarritutako itzulpengintza automatikoa.

- Erregeletan oinarritutako itzulpen automatikoa.

- Estatistiketan oinarritutako itzulpen automatikoa.