Adimen artifizial

Adimen artifiziala (AA; batzuetan, IA, inteligentzia artifiziala[1], edo (Ingelesez) AI ere) makinek frogatutako adimena da (informazioaren pertzepzioa, sintesia eta inferentzia), gizakiak ez diren animaliek edo gizakiek erakutsitako adimenari kontrajarria. Mota horretako lanen adibideak dira ahotsa ezagutzea, ordenagailuen ikusmena, hizkuntzen arteko itzulpena (naturalak) eta beste datu-konbinazio batzuk.

AAren aplikazioak dira: web-bilaketarako motor aurreratuak (adibidez, Google Search), gomendio-sistemak (YouTubek, Amazonek eta Netflixek erabiltzen dituztenak), giza hizketaren ulermena (Siri eta Alexa, esaterako), ibilgailu autonomoak (adibidez, Waymo), tresna sortzaile edo generatiboak (ChatGPT eta AA artea), erabaki automatizatuak hartzea eta maila goreneko lehia joko-sistema estrategikoetan (xakea eta Go).

Makinak gero eta gaiago bihurtzen diren heinean, "inteligentzia" eskatzen duten zereginak AAren definiziotik ezabatzen dira askotan, AA efektua bezala ezagutzen den fenomenoa[2]. Adibidez, karaktereen ezagupen optikoa AA gisa hartzen denetik kanpo utzi ohi da, ohiko teknologia bihurtu baita[3].

Adimen artifiziala diziplina akademiko gisa sortu zen 1956an, eta, ordutik, hainbat baikortasun-bolada izan ditu[4][5]; ondoren, etsipena eta finantziazio-galera ("AAren negua" esaten zaiona), eta, ondoren, ikuspegi berriak, arrakasta eta finantzaketa berritua. AAko ikerketak ikuspegi desberdin asko probatu eta baztertu ditu, hala nola garunaren simulazioa, gizakiek problemen ebazpenaren modelatzea, logika formala, ezagutzaren datu-base handiak eta animalien portaeraren imitazioa. XXI. mendeko lehen hamarkadetan, ikaskuntza automatiko matematiko eta estatistiko handia nagusi izan da eremuan, eta teknika hori oso arrakastatsua izan dela erakutsi du industria eta mundu akademiko osoan erronkazko arazo asko konpontzen lagunduz[6].

AAko ikerketaren azpieremuak helburu zehatzetan eta tresna espezifikoen erabileran oinarritzen dira. AAko ikerketaren helburu tradizionalen artean daude arrazoitzea, ezagutza irudikatzea, planifikatzea, ikastea, hizkuntza naturala prozesatzea, pertzepzioa eta objektuak mugitzeko eta manipulatzeko gaitasuna. Adimen orokorra (arazo arbitrario bat konpontzeko gaitasuna) da eremu horren epe luzerako helburuetako bat. Arazo horiek konpontzeko, AAko ikertzaileek problemak ebazteko teknika ugari egokitu, eta integratu dituzte, hala nola bilaketa eta optimizazio matematikoa, logika formala, sare neuronal artifizialak eta estatistikan, probabilitatean eta ekonomian oinarritutako metodoak. Informatikan, psikologian, hizkuntzalaritzan, filosofian eta beste arlo askotan ere oinarritzen da AA.

Giza adimena "hain zehatz deskribatu daiteke, ezen simulatzen duen makina bat egin daitekeen" ustean sortu zen eremua. Honek giza adimenaren antzekoa gaitasuna zuten izaki artifizialak sortzearen eta ondorio etikoen gaineko argudio filosofikoak sorrarazi zituen; gai hauek antzinatik aztertu zituzten mitoak, fikzioak eta filosofiak. Ordutik, informatikariek eta filosofoek iradoki dute AA arrisku existentzial bihur daitekeela gizateriarentzat, haien gaitasun arrazionalak helburu onuragarrietara bideratzen ez badira. Adimen artifiziala ere kritikatu izan da AAren benetako gaitasun teknologikoak puzteagatik.

Terminoaren definizioari buruz

[aldatu | aldatu iturburu kodea]Lagunartean, adimen artifiziala terminoa makina batek gizakiek beste gizakien adimenekin lotzen dituzten funtzio «kognitiboak» imitatzen dituenean aplikatzen da, adibidez: «hautematean», «arrazoitzean», «ikastean» eta «arazoak konpontzean»[7]. Andreas Kaplanek eta Michael Haenleinek honela definitzen dute adimen artifiziala: «Sistema batek kanpoko datuak behar bezala interpretatzeko duen gaitasuna, datu horietatik ikasteko eta ezagutza horiek egokitzapen malguaren bidez zeregin eta xede zehatzak lortzeko erabiltzeko duen gaitasuna»[8]. Gorka Azkunek atazen araberako definizio bat ematen du: «Ezin dugunez besterik gabe esan makina batek adimena daukan edo ez, egiten duguna da makina horri ataza batzuk jarri, gure ustez izaki adimentsu batek bakarrik ebatzi litzakeenak, eta ikusten dugu makinak zenbateraino ondo egiten dituen ataza horiek».[9] Makinak gero eta gai bihurtzen diren heinean, noizbait giza- eta adimen-beharra zegoela pentsatu izan den teknologia hori ezabatu egiten da definiziotik.

Adibidez, karaktereen ezagupen optikoa ez da jada «adimen artifizialaren» adibidetzat hartzen, teknologia arrunt bihurtu baita[10]. Oraindik, adimen artifizial gisa sailkatuta dauden aurrerapen teknologikoak gidatzeko sistema autonomoak edo xakean edo Go jokatzeko gai direnak dira[8].

Adimen artifiziala arazoak konpontzeko modu berri bat da, eta horien barruan sartzen dira sistema adituak, roboten maneiua eta kontrola eta prozesadoreak. Sistema horietan, ezagutza integratzen saiatzen da, beste era batera esanda, bere programa propioa idazteko gai den sistema adimendun bat. Arlo jakin bati buruzko ezagutza biltegiratzeko eta erabiltzeko gai den programazio-egitura gisa definitutako sistema aditu bat, ikasteko gaitasuna dakarrena[11]. Era berean, makinek algoritmoak erabiltzeko, datuetatik ikasteko eta erabakiak hartzerakoan ikasitakoa gizaki batek egingo lukeen moduan erabiltzeko gaitasuntzat har daiteke adimen artifiziala; gainera, adimen artifizialaren ikuspegi nagusietako bat ikaskuntza automatikoa da, eta, beraz, ordenagailuek edo makinek ikasteko gaitasuna dute horretarako programatuta egon gabe[12].

Takeiasen arabera (2007), AA zientzia konputazionalen adar bat da, gizakien berezko jarduerak egiteko gai diren zenbaketa-ereduak aztertzeaz arduratzen dena, haien bi ezaugarri nagusitan oinarrituta: arrazoiketa eta jokabidea[13].

1956an, John McCarthyk «adimen artifiziala» esamoldea sortu zuen, eta honela definitu zuen: «makina adimendunak egiteko zientzia eta asmamena, batez ere konputazio adimenduneko programak»[14].

Era berean, hainbat pertzepzio eta ekintza mota daude, sentsore fisiko eta sentsore mekanikoen bidez lortu eta ekoitzi daitezkeenak, hurrenez hurren, makinetan, pultsu elektriko edo optikoen bidez konputagailuetan, bai eta software baten eta software-ingurunearen bit-sarreren eta -irteeren bidez ere.

Hona hemen adibide batzuk: sistemen kontrola, plangintza automatikoa, diagnostikoei eta kontsumitzaileen kontsultei erantzuteko gaitasuna, idazketaren ezagutza, hizketaren ezagutza eta patroien ezagutza. Gaur egun, AAko sistemak errutinaren parte dira ekonomian, medikuntzan, ingeniaritzan, garraioan, komunikazioetan eta milizian, eta programa informatiko, konputagailuko xake bezalako estrategia-joko eta beste bideojoko askotan erabili izan da.

Historia

[aldatu | aldatu iturburu kodea]Aurrekariak

[aldatu | aldatu iturburu kodea]Adimen artifizialaren jatorria psikologian bertan datza, zehazki giza pentsamenduaren modelo bat sortzeko nahian. Adimen artifizialaren kontzeptua aspaldidanik gizakiak amestu izan duen ahalmen batekin erlazionaturik dago, materia bizigabea bizteko ahalmenarekin. Pragako Golemaren kondairan eta modernoagoa den Frankenstein doktorearen kontakizunean nabari liteke antzekorik. Hala ere, dakigunez Samuel Butler, Zeelanda Berrian bizitako idazle Britaniarra izan zen gaur egun darabilgun kontzeptuaren lehen zantzuak adierazi zituena, 1863an Darwin makinen artean izeneko idazki batean kontzientzia mekanikoa aipatu zuenean.

Hala dirudien arren adimen artifiziala ez da soilik robotikarekin zerikusia duen zientzia; adimen kolektiboaren azterketa izan da adimen artifizialaren sustatzaileetako bat soziologiak, biologiak, zientzia politikoek, marketinak... aspaldidanik aurreikusi nahi izan dituzte gizakien joerak eta erabakiak horretarako adimen artifiziala modelo bezala erabili litekeelarik.

Lehen ekimenak

[aldatu | aldatu iturburu kodea]1940ko hamarkadan hasi ziren adimen artifiziala informatikaren bidez lortzeko lehen ekimenak, ildo horretatik agertu ziren ere lehen idazki eta artikuluak besteak beste: 1943. urtean Warren McCulloch eta Walter Pittsek argitaratutako Logika kalkuluak, ideia Immanenteak eta Nerbioen Aktibitateak edota 1950. urtean azaldu ziren Alan Turingen Makinaria konputagailua eta inteligentzia eta J.C.R. Licklidereen Izaki-konputagailu sinbiosia.

Honen aurretik, 1948. urtean, John von Neumann eta E.T. Jaynesek jada honakoa esana zioten makinek pentsatzeko ahalmena sekula lortuko ez zutela esan zuen ikasle bati "Makinek egin ezin dituzten gauzak badirelakoan jarraitzen duzu. Argi eta zehatz esango bazenit zer den egin ezin dezaketena orduan diozun hori egiteko ahalmena duen makina bat eraikiko dut!".

1969an McCarthyk eta Hayesek frame arazoei buruzko aurkikuntza bat egin zuten eta beraien idazlanetan honako hau jarri zuten, "Filosofia arazo batzuk Adimen Artifizialetik eratorriak dira".

Inteligentzia artifizialaren aurkikuntzak

[aldatu | aldatu iturburu kodea]1950. urtean Allen Newell eta Herbert Simonek Carnegie Mellon Unibertsitateko laborategian adimen artifiziala lortzeko lehen saiakerak burutu zituzten. Hauen ondoren 1959. urtean McCarthy eta Marvin Minskyk ere MITko Adimen Artifizial Laborategian zenbait lan egin zuten.

Historikoki, bi ikerketa-bide daude adimen artifizialaren arloan - "neats"ena eta "scruffies"ena. "Neat", klasikoa edo sinbolikoa dugu AAren arloan, orokorrean, manipulazio sinbolikoz inguraturik dago eta kontzeptu abstraktuez, eta hau da gehien erabiltzen den metodologia adituen esanetan sistemen arloan. Paralelikoki "scruffy", edo "konexionista", gehiago hurbiltzen da, neurona-sare artifizialera. Hauek dira adibiderik onenak, sistema eta antolakuntza berriak eraikiz adimenera "inguratzen" saiatzen direnak eta prozesu automatiko eta sistematiko asko hobetuz arazo hau amaitzen dute dena osatuz. Biak nahikotxo hurbiltzen dira IAren historiara. 1960 eta 1970. urtean "scruffy" hurbildu zen "background"era, baina interesa gauzatu zen 1980. urtean "neat"en mugak argi geratu zirenean. Bestalde, gaur egun biak erabiltzen dira bata bestea osatuz hobeto funtzionatzen baitute.

Adimen artifiziala eta informatika

[aldatu | aldatu iturburu kodea]Adimen artifizialaren hasiera ordenagailuenarekin batera izan zen, 1956. urtean John McCarthyk adimen artifizialaren terminoa sortu zuen, eta ordutik ondorengo etapak ezberdintzen dira:

- Hasierako azterketa zientifikoaren etapa ( 1956-1970 ). Bilaketa heuristikoaren metodoak eta dedukzio-automatikoarenak ere agertzen dira. Lehenengoek problemak grafikoez adierazi eta ebazteko teknika heuristikoak erabiltzen dituzte, eta bigarrenek, logikan oinarritutakoak. Etapa honetan agertu zen LISP hizkuntza adimen artifizialerako egokituta, eta baita ere sare semantikoak ezagupena adierazteko.

- Prototipoen etapa ( 1970-1980 ): Aurreko etapako fundamentu teorikoek prototipo batzuen agerraldia eragintzen dute: STRIPS proiektua roboten planifikazioan, gizakien hizkuntza ulertzeko MARCO ezagupenen adierazpen-paradigma, lehenengo sistema adituak ( MYCIN, gaixotasunen diagnostikorako...) eta 1972 urtean programazio logikoaren planteamendua, PROLOG hizkuntza sortarazi zuena.

- Difusio-etapa. Oraingoa. Ezagupen-ingeniariaren sakabanatzea ematen da. Adimen artifizialera dedikaturiko enpresak agertzen dira, aplikazio honetarako erremintak merkatura zabaltzen. Aurrerapen handiak ematen dira sistema adituetan eta datu-baseentzako hizkuntza naturalean, eta ez hain handiak ikusmen artifizial eta robotikan.

Helburuak

[aldatu | aldatu iturburu kodea]Adimena simulatzeko (edo sortzeko) arazo orokorra azpi-arazoetan banatu da. Horiek ikertzaileek sistema adimendun batek bistaratzea espero duten ezaugarri edo gaitasun partikularrak dira. Jarraian deskribatutako ezaugarriek arreta gehien jaso dutenak dira, eta AA ikerketaren esparrua hartzen dute[a]

Arrazoiketa, arazoak konpontzea

[aldatu | aldatu iturburu kodea]Puzzleak ebazten dituztenean edo dedukzio logikoak egiten dituztenean gizakiek erabiltzen duten pausoz pausoko arrazonamendua imitatzen zuten algoritmoak garatu zituzten lehen ikertzaileek[15] 1980ko eta 1990eko hamarkadaren amaieran, ziurgabetasuna edo informazio osatugabea lantzeko metodoak garatu ziren, probabilitatea eta ekonomia kontzeptuak erabiliz[16].

Algoritmo horietako asko ez dira nahikoak arrazoimen-arazo handiak ebazteko leherketa konbinatzailea jasaten dutelako: esponentzialki moteltzen zihoazen arazoak handitu ahala[17]. Gizakiek ere oso gutxitan erabiltzen dute AAren ikerketa goiztiarrek modelatu dezaketen urratsez urratseko dedukzioa. Arazo gehienak judizio azkarrak eta intuitiboak erabiliz ebazten dituzte[18]. Arrazoiketa zehatza eta eraginkorra konpondu gabeko arazoa da.

Ezagutzaren irudikapena

[aldatu | aldatu iturburu kodea]

Ezagutzaren irudikapenak eta ezagutzaren ingeniaritzak[19] AA programek galderei modu adimentsuan erantzutea eta mundu errealeko gertakariei buruzko dedukzioak egitea ahalbidetzen dute. Ezagutza formalaren irudikapenak edukietan oinarritutako indexazio eta berreskurapenean erabiltzen dira[20] eszenaren interpretazioan[21], erabaki klinikoen laguntzan[22], ezagutzaren aurkikuntzan (datu-base handietako inferentzia interesgarriak eta ekingarriak ateratzea)[23] eta beste arlo batzuetan[24].

Ezagutza-oinarria programa batek erabil dezakeen forma batean irudikatzen den ezagutza-multzo bat da. Ontologia ezagutza-eremuak erabiltzen dituen objektu, erlazio, kontzeptu eta propietateen multzoa da[25]. Ezagutza oinarriek honako gauzak irudikatu behar dituzte: objektuak, propietateak, kategoriak eta objektuen arteko erlazioak[26]; egoerak, gertaerak, aldarteak eta denbora[27]; kausak eta ondorioak[28]; ezagutzari buruzko ezagutza (besteek dakigunari buruz dakiguna)[29]; arrazoibide lehenetsia (gizakiak bere gain hartzen dituen gauzak egiazkoak dira bestela esan arte, eta egia izaten jarraituko dute beste gertakari batzuk aldatzen ari direnean ere)[30], eta beste hainbat alderdi eta jakintza-eremuak.

Ezagutza irudikapenaren arazo zailenen artean, honako hauek dira: zentzu komunaren ezagutzaren zabalera (gertakari atomikoen ezagutza duen batezbesteko pertsona multzoa izugarria da)[31] eta zentzu arruntaren ezagutza gehienen forma azpisinbolikoa (jendeak dakienaren zati handi bat ez da hitzez adieraz ditzakeen gertakari edo adierazpen gisa adierazten), eta zentzu arruntaren ezagutza gehienen forma azpisinbolikoa (jendeak dakienaren zati handi bat ez da ahoz adieraz litezkeen "gertakari" edo "adierazpen" gisa irudikatuta)[18].

Ezagutza eskuratzea AA aplikazioetarako, ezagutza lortzea da arazorik larriena[b]. AA modernoak ezagutzak Interneten biltzen ditu (Wikipedia barne). Ezagutza bera informazioa argitaratu zuten boluntarioek eta profesionalek bildu zuten (bere lana AA enpresei ematea adostuta edo ez)[32]. Iturri kolektibo teknika horrek ez du bermatzen ezagutza zuzena edo fidagarria denik. Hizkuntz eredu handien ezagutza (adibidez, Chat-GPT) ez da oso fidagarria, desinformazioa eta faltsukeriak ematen baititu (haluzinazio hitzez ezagutua). AA aplikazio moderno hauetarako, ezagutza zehatza ematea konpondu gabeko arazoa da.

Plangintza eta erabakiak hartzea

[aldatu | aldatu iturburu kodea]Agentea munduan ekintzak hautematen eta egiten dituen edozer da. Agente arrazionalak helburuak edo lehentasunak ditu, eta horiek gauzatzeko ekintzak egiten ditu[c][33]. Plangintza automatizatuan, agenteak helburu zehatz bat du[34]. Erabakiak hartzeko modu automatizatuan, agenteak lehentasunak ditu: egon nahiko lukeen egoera batzuk daude, eta saihestu nahiko lituzkeen egoera batzuk daude. Erabakiak hartzen duen agenteak egoera bakoitzari (erabilgarritasuna deitzen zaio) zenbaki bat esleitzen dio agenteak zenbat nahiago duen neurtzen duena. Ekintza posible bakoitzerako, «espero den erabilgarritasuna» kalkula dezake: ekintzaren emaitza posible guztien erabilgarritasuna, emaitza gertatzeko probabilitatearen arabera haztatuta. Ondoren, espero den erabilgarritasun handiena duen ekintza aukera dezake[35].

Plangintza klasikoan, agenteak badaki zehatz-mehatz zein izango den edozein ekintzaren eragina[36]. Mundu errealeko arazo gehienetan, ordea, litekeena da agentea ziur ez izatea zein egoeratan dagoen (ezezaguna edo behatu ezina da) eta litekeena da ziur ez jakitea zer gertatuko den ekintza posible bakoitzaren ondoren (ez da determinista). Ekintza bat aukeratu behar du probabilitatezko asmakizun bat eginez, eta, ondoren, egoera berriro ebaluatu, ekintzak funtzionatu duen ikusteko[37]. Arazo batzuetan, agentearen hobespenak zalantzazkoak izan daitezke, batez ere tartean dauden beste agente edo gizaki batzuk badaude. Horiek ikas daitezke (adibidez, alderantzizko errefortzuaren ikaskuntzarekin) edo agenteak informazioa bilatu dezake bere lehentasunak hobetzeko[38]. Informazio-balioaren teoria esplorazio- edo esperimentazio-ekintzen balioa neurtzeko erabil daiteke[39]. Etorkizuneko ekintzen eta egoeren espazioa ezinezkoa da normalean, beraz, eragileek ekintzak egin, eta egoerak ebaluatu behar dituzte azken emaitza zein izango den ziur egon gabe.

Markov-en erabaki-prozesu batek ekintza jakin batek egoera modu jakin batean aldatzeko probabilitatea deskribatzen duen trantsizio-eredu bat du, eta egoera bakoitzaren erabilgarritasuna eta ekintza bakoitzaren kostua ematen dituen sari-funtzioa. Politika batek erabaki bat egoera posible bakoitzarekin lotzen du. Politika kalkula liteke (adibidez, iterazio bidez); heuristikoa izan daiteke, edo ikasi daiteke[40].

Jokoen teoriak elkarreraginean dauden hainbat agenteren jokaera arrazionala deskribatzen du, eta beste agente batzuk inplikatzen dituzten erabakiak hartzen dituzten AA programetan erabiltzen da[41].

Ikaskuntza

[aldatu | aldatu iturburu kodea]Ikasketa automatikoa zeregin jakin batean beren errendimendua automatikoki hobetu dezaketen programen azterketa da[42]. AAren parte izan da hasieratik[d].

Ikaskuntza automatikoko hainbat mota daude. Gainbegiratu gabeko ikaskuntzak datu-jario bat aztertzen du; ereduak aurkitzen ditu, eta iragarpenak egiten ditu beste inongo orientaziorik gabe[45]. Gainbegiratutako ikaskuntzak gizaki batek sarrerako datuak etiketatu behar ditu lehenik, eta bi mota nagusitan daude: sailkapena (non programak sarrera zein kategoriari dagokion iragartzen ikasi behar duen) eta erregresioa (non programak zenbakizko sarreran oinarritutako funtzio numeriko bat ondorioztatu behar duen)[46]. Indartze-ikaskuntzan, agentea erantzun onengatik saritzen da, eta txarengatik zigortzen da. Agenteak onak gisa sailkatutako erantzunak aukeratzen ikasten du[47]. Transferentzia ikaskuntza arazo batetik lortutako ezagutza arazo berri bati aplikatzen zaionean da[48]. Ikaskuntza sakonak neurona-sare artifizialak erabiltzen ditu ikaskuntza mota guztietarako.

Ikaskuntza konputazionalaren teoriak ikasleak konplexutasun konputazionalaren arabera ebalua ditzake, laginaren konplexutasunaren arabera (zenbat datu behar diren) edo beste optimizazio nozio batzuen arabera[49].

Hizkuntza naturalaren prozesamendua

[aldatu | aldatu iturburu kodea]Arlo honetan sartzen dira:

- Hizkuntza idatzia ezagutzen duten sistemak, adibidez datu-baseak kontsultatzeko

- Ahozko hizkuntza jaso eta idazten duten sistemak

- Ahozko hizkuntzen bat-bateko itzulpen sistemak. Hauek oraindik ez daude hain aurreratuta.

Pertsonek euren artean hitz egiterakoan, mezuaz gain beste hainbat ezagutza komun dituzte: ingurukoena. Lengoaia naturalaren prozesamenduak (NLP)[50] programak ingelesa moduko giza hizkuntzetan irakurtzeko, idazteko eta komunikatzeko aukera ematen du. Arazo zehatzak honako hauek dira: hizketa-ezagutzea, hizketa-sintesia, itzulpen automatikoa, informazioa ateratzea, informazioa berreskuratzea eta galderei erantzutea[51].

Hasierako lanek, Noam Chomskyren gramatika generatibo eta sare semantikoetan oinarrituta, zailtasunak izan zituzten hitz-zentzua desanbiguatzeko[e] mikro-mundu izeneko domeinu txikietara mugatu ezean (zentzu komunaren ezagutzaren arazoa dela eta[31]).

NLPrako ikaskuntza sakoneko teknika modernoak hitzen barneratzea (hitz bat bestearen ondoan zenbat maiz agertzen den)[52], transformatzaileak (testuan ereduak aurkitzen dituena)[53] eta beste batzuk dira[54]. 2019an, aurrez prestatutako eraldatzaile sortzaileak (edo GPT ingelesez) hizkuntza-ereduak testu koherentea sortzen hasi ziren[55][56], eta 2023rako eredu horiek giza-mailako puntuazioak lortu ahal izan zituzten barraren azterketan, SAT, GRE, eta mundu errealeko beste hainbat aplikaziotan[57].

Pertzepzioa

[aldatu | aldatu iturburu kodea]Makinen pertzepzioa sentsoreen (adibidez, kamerak, mikrofonoak, hari gabeko seinaleak, lidar aktiboa, sonarra, radarra eta ukimenezko sentsoreak) munduaren alderdiak ondorioztatzeko gaitasuna da. Ordenagailu bidezko ikusmena ikusizko sarrera aztertzeko gaitasuna da[58].

Ikusmen artifiziala

[aldatu | aldatu iturburu kodea]Ikusmen artifizialaren helburua formak eta objektuak identifikatzeko gai diren sistema batzuk garatzea da. Bi dimentsioetako arloan arrakasta batzuk lortu izan dira, baina zailtasun handiagoak daude 3D kasuan. Bere aplikazioa batez ere robotikan ematen da.

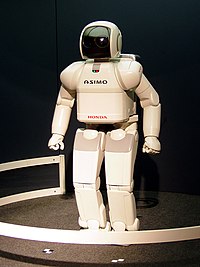

Robotika

[aldatu | aldatu iturburu kodea]Robotak osatzen dituzten sistemen ikasketa alde batetik, eta beste alde batetik, euren adimenarena. Robot bat bere inguruko egoera identifikatu eta uneko egoera beste egoera objektibo batera pasatzeko gai den sistema bat da, horretarako zeregin batzuk planifikatzen. Oso konplexuak dira bai identifikazioa bai zereginen planifikazioa egoeraz aldatzeko.

Sistema adituak

[aldatu | aldatu iturburu kodea]Sistema adituek normalean gizaki adituek ebazten dituen problemak ebazten dituzte, etekin antzekoaz. Horretarako ezagupen basea handia behar dute eremuari buruz, mekanismo bat ezagupen horiek aplikatzeko eta beste bat erabiltzaileari azaltzeko zer egin den. Jakintza berria sistemara gehitzeko kapaz izan behar dute, eta baita ere lan egiteko nahiz eta jakintza osoa ez izan.

Irakaskuntza

[aldatu | aldatu iturburu kodea]Zaila da aurreikustea adimen artifizialak zelako ekarpenak ekarriko dituen datozen urteotan gizakion ikaskuntza bideetan[59][60][61].

Oharrak

[aldatu | aldatu iturburu kodea]- ↑ Ezaugarri adimentsuen zerrenda hau AA testu-liburu nagusiek landutako gaietan oinarritzen da, besteak beste: (Russell & Norvig 2021), (Luger & Stubblefield 2004), (Poole, Mackworth & Goebel 1998) and (Nilsson 1998)

- ↑ Sistema adituek ezagutza atzemateko eraginkorrak ez zirela frogatu zuten arrazoien artean dago

- ↑ Agente arrazionala ekonomian, filosofian eta adimen artifizial teorikoan erabiltzen den termino orokorra da. Bere jokabidea helburuak betetzera bideratzen duen edozeri erreferentzia egin diezaioke, hala nola pertsona bati, animaliei, korporazio bati, nazio bati edo, AAren kasuan, programa informatiko bati.

- ↑ Alan Turing discussed the centrality of learning as early as 1950, in his classic paper "Computing Machinery and Intelligence".[43] 1956an, Dartmouth AA jatorrizko udako konferentzian, Ray Solomonoff-ek gainbegiratu gabeko ikaskuntza automatiko probabilistikoari buruzko txosten bat idatzi zuen: An Inductive Inference Machine.[44]

- ↑ See Txantiloi:Section link

Erreferentziak

[aldatu | aldatu iturburu kodea]- ↑ 31eskutik. (2023-12-13). «Sigla lexikalizatuak» 31 eskutik (Noiz kontsultatua: 2023-12-15).

- ↑ McCorduck 2004, 204 orr. .

- ↑ Schank 1991, 38 orr. .

- ↑ Crevier 1993, 109 orr. .

- ↑ 1980ko hamarkadaren hasieran garatu ziren lehenengo proiektuak: Fifth Generation Project (Japonia), Alvey (Erresuma Batua), Microelectronics and Computer Technology Corporation (AEB), Strategic Computing Initiative (AEB):

- (McCorduck 2004, 426–441 orr. )

- (Crevier 1993, 161–162,197–203, 211, 240 orr. )

- (Russell & Norvig 2003, 24 orr. )

- (NRC 1999, 210–211 orr. )

- (Newquist 1994, 235–248 orr. )

- ↑ Clark 2015b.

- ↑ , Russell & Norvig 2009, 2 orr. .

- ↑ a b (Ingelesez) «Siri, Siri, in my hand: Who’s the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence - ScienceDirect» web.archive.org 2018-11-21 (Noiz kontsultatua: 2023-02-05).

- ↑ Arruabarrena, Isabel Jaurena-Mikel P. Ansa- Jone. «FIKZIOTIK ERREALITATERA» Berria (Noiz kontsultatua: 2023-04-16).

- ↑ Schank, Roger C. (1991). «Where's the AI» (PDF). AI Magazine 12 (4): 38

- ↑ (Gaztelaniaz) Ingelek. (1986). Biblioteca Basica Informatica 28 Inteligencia Artificial. (Noiz kontsultatua: 2023-02-05).

- ↑ (Gaztelaniaz)Rouhiainen, Lasse (2018). Inteligencia Artificial 101 cosas que debes saber hoy sobre nuestro futuro. Alienta. 2021ean begiratua

- ↑ (Gaztelaniaz)López Takeyas, Bruno. «Introducción a la Inteligencia Artificial»

- ↑ (Ingelesez) «Basic Questions» www-formal.stanford.edu (Noiz kontsultatua: 2023-02-05).

- ↑

Arazoak ebaztea, puzzleak ebaztea, jolasa eta dedukzioa:

- (Russell & Norvig 2021, chpt. 3–5)

- (Russell & Norvig 2021, chpt. 6) (constraint satisfaction)

- (Poole, Mackworth & Goebel 1998, chpt. 2,3,7,9)

- (Luger & Stubblefield 2004, chpt. 3,4,6,8)

- (Nilsson 1998, chpt. 7–12)

- ↑

Arrazoiketa ziurgabea:

- (Russell & Norvig 2021, chpt. 12–18)

- (Poole, Mackworth & Goebel 1998, 345–395 orr. )

- (Luger & Stubblefield 2004, 333–381 orr. )

- (Nilsson 1998, chpt. 7–12)

- ↑

Trataezintasuna eta eraginkortasuna eta leherketa konbinatorioa:

- (Russell & Norvig 2021, 21 orr. )

- ↑ a b Prebalentziaren arrazonamendu eta ezagutza azpisinbolikoaren froga psikologikoak:

- ↑

Ezagutzaren irudikapena eta ezagutzaren ingeniaritza:

- (Russell & Norvig 2021, chpt. 10)

- (Poole, Mackworth & Goebel 1998, 23–46, 69–81, 169–233, 235–277, 281–298, 319–345 orr. )

- (Luger & Stubblefield 2004, 227–243 orr. ),

- (Nilsson 1998, chpt. 17.1–17.4, 18)

- ↑ Smoliar & Zhang 1994.

- ↑ Neumann & Möller 2008.

- ↑ Kuperman, Reichley & Bailey 2006.

- ↑ McGarry 2005.

- ↑ Bertini, Del Bimbo & Torniai 2006.

- ↑ Russell & Norvig 2021, 272 orr. .

- ↑

Kategoriak eta erlazioak irudikatzea: Semantika sareak, Deskribapen logika, herentzia (markoa eta gidoia barne):

- (Russell & Norvig 2021, §10.2 & 10.5),

- (Poole, Mackworth & Goebel 1998, 174–177 orr. ),

- (Luger & Stubblefield 2004, 248–258 orr. ),

- (Nilsson 1998, chpt. 18.3)

- ↑ Gertaerak eta denbora irudikatzea:Egoeraren kalkuluak, gertaeren kalkuluak, kalkulu arinak (marko arazoak konpontzea barne):

- (Russell & Norvig 2021, §10.3),

- (Poole, Mackworth & Goebel 1998, 281–298 orr. ),

- (Nilsson 1998, chpt. 18.2)

- ↑

Kalkulu kausala:

- (Poole, Mackworth & Goebel 1998, 335–337 orr. )

- ↑

Ezagutzaren inguruko ezagutzak irudikatzea: Sinesmen-kalkulua, logika modalak:

- (Russell & Norvig 2021, §10.4),

- (Poole, Mackworth & Goebel 1998, 275–277 orr. )

- ↑

Arrazoibide lehenetsia, marko arazoa, logika lehenetsia, logika ez monotonikoa, zirkunskripzioa, Mundu itxiaren suposizioa, arrazoibide abduktiboa:

- (Russell & Norvig 2021, §10.6)

- (Poole, Mackworth & Goebel 1998, 248–256, 323–335 orr. )

- (Luger & Stubblefield 2004, 335–363 orr. )

- (Nilsson 1998, ~18.3.3)

- ↑ a b

Zentzu komunaren ezagutza zabala:

- (Lenat & Guha 1989, Introduction)

- (Crevier 1993, 113–114 orr. ),

- (Moravec 1988, 13 orr. ),

- (Russell & Norvig 2021, 241, 385, 982 orr. ) (arazoen kualifikazioa)

- ↑ Gertner 2023.

- ↑ Russell & Norvig 2021, 528 orr. .

- ↑ Plangintza eta programazio automatizatua:

- (Russell & Norvig 2021, chpt. 11)

- ↑

Erabaki automatizatua, Erabakien teoria:

- (Russell & Norvig 2021, chpt. 16–18)

- ↑

Plangintza klasikoa:

- (Russell & Norvig 2021, Section 11.2)

- ↑

Sentsorerik gabe edo konforme plangintza, planifikazio kontingentea, birplanifikazioa:

- (Russell & Norvig 2021, Section 11.5)

- ↑

Hobespen ziurgabeak:

- (Russell & Norvig 2021, Section 16.7)

- (Russell & Norvig 2021, Section 22.6)

- ↑

Informazioaren balioaren teoria:

- (Russell & Norvig 2021, Section 16.6)

- ↑

Markov-en erabaki prozesua:

- (Russell & Norvig 2021, chpt. 17)

- ↑

Jokoen teoria eta eragile anitzeko erabakien teoria:

- (Russell & Norvig 2021, chpt. 18)

- ↑

Ikasketa automatikoa:

- (Russell & Norvig 2021, chpt. 19–22)

- (Poole, Mackworth & Goebel 1998, 397–438 orr. )

- (Luger & Stubblefield 2004, 385–542 orr. )

- (Nilsson 1998, chpt. 3.3, 10.3, 17.5, 20)

- ↑ Turing 1950.

- ↑ Solomonoff 1956.

- ↑

Gainbegiratu gabeko ikaskuntza:

- (Russell & Norvig 2021, 653 orr. ) (definizioa)

- (Russell & Norvig 2021, 738–740 orr. ) (kluster azterketa)

- (Russell & Norvig 2021, 846–860 orr. ) (hitz txertatzea)

- ↑

Supervised learning:

- (Russell & Norvig 2021, §19.2) (Definizioa)

- (Russell & Norvig 2021, Chpt. 19–20) (Teknikoak)

- ↑

Indartze ikaskuntza:

- (Russell & Norvig 2021, chpt. 22)

- (Luger & Stubblefield 2004, 442–449 orr. )

- ↑

Transferentzia ikaskuntza:

- (Russell & Norvig 2021, 281 orr. )

- (The Economist 2016)

- ↑

Ikaskuntza konputazionalaren teoria:

- (Russell & Norvig 2021, 672–674 orr. )

- (Jordan & Mitchell 2015)

- ↑

Lengoaia naturalaren prozesamendua (NLP):

- (Russell, Norvig & 20 21, chpt. 23–24)

- (Poole, Mackworth & Goebel 1998, 91–104 orr. )

- (Luger & Stubblefield 2004, 591–632 orr. )

- ↑

Hizkuntza naturalaren prozesamenduaren azpiarazoak (NLP):

- (Russell & Norvig 2021, 849–850 orr. )

- ↑ Russell & Norvig 2021, 856–858 orr. .

- ↑ Russell & Norvig 2021, 868–871 orr. .

- ↑ [[Hizkuntza naturalaren prozesamenduari buruzko ikuspegi estatistiko eta lengoaiaren prozesamendu modernoak|NLP]]:

- (Russell & Norvig 2021, chpt. 24)

- (Cambria & White 2014)

- ↑ Vincent 2019.

- ↑ Russell & Norvig 2021, 875–878 orr. .

- ↑ Bushwick 2023.

- ↑

Ordenagailu bidezko ikusmena:

- (Russell & Norvig 2021, chpt. 25)

- (Nilsson 1998, chpt. 6)

- ↑ (Ingelesez) «Spotlight: Let's ask more of AI» The Internet Health Report 2019 2019-03-13 (Noiz kontsultatua: 2019-05-04).

- ↑ (Ingelesez) «Anatomy of an AI System» Anatomy of an AI System (Noiz kontsultatua: 2019-05-04).

- ↑ (Ingelesez) Johnson, Eric. (2019-04-08). «How will AI change your life? AI Now Institute founders Kate Crawford and Meredith Whittaker explain.» Vox podcasts (Noiz kontsultatua: 2019-05-04).

Bibliografia

[aldatu | aldatu iturburu kodea]AA testu-liburuak

[aldatu | aldatu iturburu kodea]2023an gehien erabiltzen diren bi testuliburuak (Ikus Programa Irekia) dira:

- (Ingelesez) Russell, Stuart J; Norvig, Peter. (2021). Artificial Intelligence: A Modern Approach, 4. ed.. Pearson, Hoboken ISBN 978-0134610993.. LCCN 20190474

- (Ingelesez) Rich, Elaine; Knight, Kevin; Nair, Shivashankar B. (2010). Artificial Intelligence. (3.. argitaraldia) Tata McGraw Hill India (New Delhi) ISBN 978-0070087705..

Hauek izan ziren 2008an gehien erabili ziren lau AA testu-liburuak:

- Luger, George; Stubblefield, William. (2004). Artificial Intelligence: Structures and Strategies for Complex Problem Solving. Benjamin/Cummings ISBN 978-0-8053-4780-7..

- Nilsson, Nils. (1998). Artificial Intelligence: A New Synthesis. Morgan Kaufmann ISBN 978-1-55860-467-4..

- Russell, Stuart J. (2003). Artificial Intelligence: A Modern Approach. Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2.

- Poole, David; Mackworth, Alan; Goebel, Randy. (1998). Computational Intelligence: A Logical Approach. Oxford University Press ISBN 978-0-19-510270-3..

Ondorengo edizioak. Poole, David; Mackworth, Alan. (2017). Artificial Intelligence: Foundations of Computational Agents. Cambridge University Press ISBN 978-1-107-19539-4..

AAren historia

[aldatu | aldatu iturburu kodea]- Newquist, HP. (1994). The Brain Makers: Genius, Ego, And Greed In The Quest For Machines That Think. Macmillan/SAMS ISBN 978-0-672-30412-5..

- Nilsson, Nils. (2009). The Quest for Artificial Intelligence: A History of Ideas and Achievements. Cambridge University Press ISBN 978-0-521-12293-1..

Beste iturri batzuk

[aldatu | aldatu iturburu kodea]- Urbina, Fabio; Lentzos, Filippa; Invernizzi, Cédric; Ekins, Sean. (7 March 2022). «Dual use of artificial-intelligence-powered drug discovery» Nature Machine Intelligence: 189–191. doi:. PMID 36211133..

- Rose, Steve. (11 July 2023). «AI Utopia or dystopia?» The Guardian Weekly: 42–43..

- Grant, Nico; Hill, Kashmir. (May 22, 2023). «Google's Photo App Still Can't Find Gorillas. And Neither Can Apple's.» The New York Times.

- (Ingelesez) Berdahl, Carl Thomas; Baker, Lawrence; Mann, Sean; Osoba, Osonde; Girosi, Federico. (7 February 2023). «Strategies to Improve the Impact of Artificial Intelligence on Health Equity: Scoping Review» JMIR AI: e42936. doi:. ISSN 2817-1705..

- Dockrill, Peter. (27 June 2022). Robots With Flawed AI Make Sexist And Racist Decisions, Experiment Shows. .

- Ustun, B.; Rudin, C.. (2016). «Supersparse linear integer models for optimized medical scoring systems.» Machine Learning: 349–391. doi:..

- Schmidhuber, Jürgen. (2022). Annotated History of Modern AI and Deep Learning. .

- Chen, Stephen. (25 March 2023). Artificial intelligence, immune to fear or favour, is helping to make China's foreign policy | South China Morning Post. .

- Vogels, Emily A.. (24 May 2023). «A majority of Americans have heard of ChatGPT, but few have tried it themselves» Pew Research Center.

- (Ingelesez) Kobielus, James. (27 November 2019). «GPUs Continue to Dominate the AI Accelerator Market for Now» InformationWeek.

- Gertner, Jon. (2023). «Wikipedia's Moment of Truth – Can the online encyclopedia help teach A.I. chatbots to get their facts right — without destroying itself in the process? + comment» The New York Times.

- Hornik, Kurt; Stinchcombe, Maxwell; White, Halbert. (1989). «Multilayer Feedforward Netlanas are Universal Approximators» Neural Netlanas (Pergamon Press): 359–366..

- Cybenko, G.. (1988). Continuous valued neural netlanas with two hidden layers are sufficient. Department of Computer Science, Tufts University.

- Good, I. J.. (1965). Speculations Concerning the izena Ultraintelligent Machine. .

- Wong, Matteo. (19 May 2023). ChatGPT Is Already Obsolete. .

- Christian, Brian. (2020). The Alignment Problem: Machine learning and human values. W. W. Norton & Company ISBN 978-0-393-86833-3. OCLC .1233266753.

- DiFeliciantonio, Chase. (3 April 2023). «AI has already changed the world. This report shows how» San Francisco Chronicle.

- (Ingelesez) Goswami, Rohan. (5 April 2023). «Here's where the A.I. jobs are» CNBC.

- Nilsson, Nils. (1995). Eyes on the Prize. , 9–17 or..

- McCarthy, John. (2007). «From Here to Human-Level AI» Artificial Intelligence: 171..

- Beal, J.; Winston, Patrick. (2009). «The New Frontier of Human-Level Artificial Intelligence» IEEE Intelligent Systems: 21–24. doi:..

- Bushwick, Sophie. (16 March 2023). What the New GPT-4 AI Can Do. .

- Mitchell, Tom. (1997). Machine Learning. McGraw Hill ISBN 0070428077..

- McGaughey, E. (2022). Will Robots Automate Your Job Away? Full Employment, Basic Income, and Economic Democracy. , 51(3) Industrial Law egunkaria 511–559 or. doi:..

- McCarthy, John. (1999). What is AI?. .

- Werbos, P. J.. (1988). «Generalization of backpropagation with application to a recurrent gas market model» Neural Netlanas: 339–356. doi:..

- Gers, Felix A.; Schraudolph, Nicol N.; Schraudolph, Jürgen. (2002). «Learning Precise Timing with LSTM Recurrent Netlanas» Journal of Machine Learning Research: 115–143..

- Deng, L.; Yu, D.. (2014). «Deep Learning: Methods and Applications» Foundations and Trends in Signal Processing: 1–199. doi:..

- (Ingelesez) Schulz, Hannes; Behnke, Sven. (1 November 2012). «Deep Learning» KI – Künstliche Intelligenz: 357–363. doi:. ISSN 1610-1987..

- Fukushima, K.. (2007). «Neocognitron» Scholarpedia: 1717. doi:. Bibcode: 2007SchpJ...2.1717F.. was introduced by Kunihiko Fukushima in 1980.

- Habibi, Aghdam, Hamed. (2017). Guide to convolutional neural netlanas : a practical application to traffic-sign detection and classification. ISBN 978-3319575490. OCLC .987790957.

- Ciresan, D.; Meier, U.; Schmidhuber, J.. (2012). 2012 IEEE Conference on Computer Vision and Pattern Recognition. , 3642–3649 or. doi:. ISBN 978-1-4673-1228-8..

- «From not lanaing to neural netlanaing» The Economist 2016.

- Thompson, Derek. (23 January 2014). What Jobs Will the Robots Take?. .

- Scassellati, Brian. (2002). «Theory of mind for a humanoid robot» Autonomous Robots: 13–24. doi:..

- Sample, Ian. (14 March 2017a). «Google's DeepMind makes AI program that can learn like a human» The Guardian.

- (Ingelesez) Sample, Ian. (5 November 2017b). «Computer says no: why making AIs fair, accountable and transparent is crucial» The Guardian.

- (Ingelesez) Heath, Nick. (11 December 2020). «What is AI? Everything you need to know about Artificial Intelligence» ZDNet.

- (Ingelesez) Bowling, Michael; Burch, Neil; Johanson, Michael; Tammelin, Oskari. (9 January 2015). «Heads-up limit hold'em poker is solved» Science: 145–149. doi:. ISSN 0036-8075. PMID 25574016. Bibcode: 2015Sci...347..145B..

- Solly, Meilan. (15 July 2019). This Poker-Playing A.I. Knows When to Hold 'Em and When to Fold 'Em. .

- «Artificial intelligence: Google's AlphaGo beats Go master Lee Se-dol» BBC News 12 March 2016.

- Rowinski, Dan. (15 January 2013). «Virtual Personal Assistants & The Future Of Your Smartphone [Infographic»] ReadWrite.

- Manyika, James. (2022). «Getting AI Right: Introductory Notes on AI & Society» Daedalus: 5–27. doi:..

- Markoff, John. (16 February 2011). «Computer Wins on 'Jeopardy!': Trivial, It's Not» The New York Times.

- (Ingelesez) Anadiotis, George. (1 October 2020). «The state of AI in 2020: Democratization, industrialization, and the way to artificial general intelligence» ZDNet.

- Goertzel, Ben; Lian, Ruiting; Arel, Itamar; de Garis, Hugo; Chen, Shuo. (December 2010). «A world survey of artificial brain projects, Part II: Biologically inspired cognitive architectures» Neurocomputing: 30–49. doi:..

- Robinson, A. J.; Fallside, F.. (1987). «The utility driven dynamic error propagation netlana.» Technical Report CUED/F-INFENG/TR.1 (Cambridge University Engineering Department).

- Hochreiter, Sepp. (1991). Untersuchungen zu dynamischen neuronalen Netzen. .

- Williams, R. J.; Zipser, D.. (1994). «Gradient-based learning algorithms for recurrent netlanas and their computational complexity» Back-propagation: Theory, Architectures and Applications.

- Hochreiter, Sepp; Schmidhuber, Jürgen. (1997). «Long Short-Term Memory» Neural Computation: 1735–1780. doi:. PMID 9377276..

- Goodfellow, Ian; Bengio, Yoshua; Courville, Aaron. (2016). Deep Learning. MIT Press..

- Hinton, G.; Deng, L.; Yu, D.; Dahl, G.; Mohamed, A.; Jaitly, N.; Senior, A.; Vanhoucke, V. et al.. (2012). «Deep Neural Netlanas for Acoustic Modeling in Speech Recognition – The shared views of four research groups» IEEE Signal Processing Magazine: 82–97. doi:. Bibcode: 2012ISPM...29...82H..

- Schmidhuber, J.. (2015). «Deep Learning in Neural Netlanas: An Overview» Neural Netlanas: 85–117. doi:. PMID 25462637..

- Linnainmaa, Seppo. (1970). The representation of the cumulative rounding error of an algorithm as a Taylor expansion of the local rounding errors.. Univ. Helsinki, 6–7. or..

- Griewank, Andreas. (2012). «Who Invented the Reverse Mode of Differentiation? Optimization Stories» Documenta Matematica, Extra Volume ISMP: 389–400..

- Werbos, Paul. (1974). Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences. Harvard University.

- Werbos, Paul. (1982). «Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences» System Modeling and Optimization (Springer).

- (Ingelesez) «What is 'fuzzy logic'? Are there computers that are inherently fuzzy and do not apply the usual binary logic?» Scientific American 21 October 1999.

- (Ingelesez) Merkle, Daniel; Middendorf, Martin. (2013). Search Methodologies: Introductory Tutorials in Optimization and Decision Support Techniques. Springer Science & Business Media ISBN 978-1-4614-6940-7..

- van der Walt, Christiaan; Bernard, Etienne. (2006). Data characteristics that determine classifier performance. .

- Hutter, Marcus. (2005). Universal Artificial Intelligence. Springer ISBN 978-3-540-22139-5..

- Howe, J.. (November 1994). Artificial Intelligence at Edinburgh University: a Perspective. .

- Galvan, Jill. (1 January 1997). «Entering the Posthuman Collective in Philip K. Dick's "Do Androids Dream of Electric Sheep?"» Science Fiction Studies: 413–429..

- McCauley, Lee. (2007). «AI armageddon and the three laws of robotics» Ethics and Information Technology: 153–164. doi:..

- Buttazzo, G.. (July 2001). «Artificial consciousness: Utopia or real possibility?» Computer: 24–30. doi:..

- Anderson, Susan Leigh. (2008). «Asimov's "three laws of robotics" and machine metaethics.» AI & Society: 477–493. doi:..

- Yudkowsky, E. (2008). «Artificial Intelligence as a Positive and Negative Factor in Global Risk» Global Catastrophic Risks (Oxford University Press, 2008) Bibcode: 2008gcr..book..303Y..

- Robots and Artificial Intelligence. 30 June 2017.

- Lohr, Steve. (2017). «Robots Will Take Jobs, but Not as Fast as Some Fear, New Report Says» The New York Times.

- Frey, Carl Benedikt; Osborne, Michael A. (1 January 2017). «The future of employment: How susceptible are jobs to computerisation?» Technological Forecasting and Social Change: 254–280. doi:. ISSN 0040-1625..

- Arntz, Melanie; Gregory, Terry; Zierahn, Ulrich. (2016). «The risk of automation for jobs in OECD countries: A comparative analysis» OECD Social, Employment, and Migration lanaing Papers 189.

- Morgenstern, Michael. (9 May 2015). «Automation and anxiety» The Economist.

- Mahdawi, Arwa. (26 June 2017). «What jobs will still be around in 20 urteas? Read this to prepare your future» The Guardian.

- Rubin, Charles. (Spring 2003). «Artificial Intelligence and Human Nature» The New Atlantis: 88–100..

- Bostrom, Nick. (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

- Brooks, Rodney. (10 November 2014). artificial intelligence is a tool, not a threat. .

- Sainato, Michael. (19 August 2015). Stephen Hawking, Elon Musk, and Bill Gates Warn About Artificial Intelligence. .

- Harari, Yuval Noah. (October 2018). Why Technology Favors Tyranny. .

- Robitzski, Dan. (5 September 2018). Five experts share what scares them the most about AI. .

- Goffrey, Andrew. (2008). Software studies: a lexicon. MIT Press, 15–20 or. ISBN 978-1-4356-4787-9..

- Lipartito, Kenneth. (6 January 2011). The Narrative and the Algorithm: Genres of Credit Reporting from the Nineteenth Century to Today. doi:..

- Goodman, Bryce; Flaxman, Seth. (2017). «EU regulations on algorithmic decision-making and a 'right to explanation'» AI Magazine: 50. doi:..

- (Ingelesez) Commentary: Bad news. Artificial intelligence is biased. 12 January 2019.

- (Ingelesez) Larson, Jeff; Angwin, Julia. (23 May 2016). How We Analyzed the COMPAS Recidivism Algorithm. .

- Müller, Vincent C.; Bostrom, Nick. (2014). «Future Progress in Artificial Intelligence: A Poll Among Experts» AI Matters: 9–11. doi:..

- Cellan-Jones, Rory. (2 December 2014). «Stephen Hawking warns artificial intelligence could end mankind» BBC News.

- Rawlinson, Kevin. (29 January 2015). «Microsoft's Bill Gates insists AI is a threat» BBC News.

- Holley, Peter. (28 January 2015). «Bill Gates on dangers of artificial intelligence: 'I don't understand why some people are not concerned'» The Washington Post ISSN 0190-8286..

- Gibbs, Samuel. (27 October 2014). «Elon Musk: artificial intelligence is our biggest existential threat» The Guardian.

- Bostrom, Nick. (2015). What happens when our computers get smarter than we are?. TED (conference).

- (Ingelesez) Thibodeau, Patrick. (25 March 2019). Oracle CEO Mark Hurd sees no reason to fear ERP AI. .

- Bhardwaj, Prachi. (24 May 2018). Mark Zuckerberg responds to Elon Musk's paranoia about AI: 'AI is going to... help keep our communities safe.'. .

- Geist, Edward Moore. (9 August 2015). Is artificial intelligence really an existential threat to humanity?. .

- Madrigal, Alexis C.. (27 February 2015). The case against killer robots, from a guy actually lanaing on artificial intelligence. .

- Lee, Timothy B.. (22 August 2014). Will artificial intelligence destroy humanity? Here are 5 reasons not to worry.. .

- Regulation of artificial intelligence in selected jurisdictions. OCLC .1110727808.

- Berryhill, Jamie; Heang, Kévin Kok; Clogher, Rob; McBride, Keegan. (2019). Hello, World: Artificial Intelligence and its Use in the Public Sector. OECD Observatory of Public Sector Innovation.

- Barfield, Woodrow; Pagallo, Ugo. (2018). Research handbook on the law of artificial intelligence. ISBN 978-1-78643-904-8. OCLC .1039480085.

- Iphofen, Ron; Kritikos, Mihalis. (3 January 2019). «Regulating artificial intelligence and robotics: ethics by design in a digital society» Contemporary Social Science: 170–184. doi:. ISSN 2158-2041..

- Wirtz, Bernd W.; Weyerer, Jan C.; Geyer, Carolin. (24 July 2018). «Artificial Intelligence and the Public Sector – Applications and Challenges» International egunkaria of Public Administration: 596–615. doi:. ISSN 0190-0692..

- Buiten, Miriam C. (2019). «Towards Intelligent Regulation of Artificial Intelligence» European egunkaria of Risk Regulation: 41–59. doi:. ISSN 1867-299X..

- Wallach, Wendell. (2010). Moral Machines. Oxford University Press.

- (Ingelesez) Brown, Eileen. (5 November 2019). Half of Americans do not believe deepfake news could target them online. .

- (Ingelesez) Frangoul, Anmar. (14 June 2019). A Californian business is using A.I. to change the way we think about energy storage. .

- «The Economist Explains: Why firms are piling into artificial intelligence» The Economist 31 March 2016.

- Lohr, Steve. (28 February 2016). «The Promise of Artificial Intelligence Unfolds in Small Steps» The New York Times.

- Smith, Mark. (22 July 2016). «So you think you chose to read this article?» BBC News.

- Aletras, N.; Tsarapatsanis, D.; Preotiuc-Pietro, D.; Lampos, V.. (2016). «Predicting judicial decisions of the European Court of Human Rights: a Natural hizkuntza Processing perspective» PeerJ Computer Science: e93. doi:..

- Cadena, Cesar; Carlone, Luca; Carrillo, Henry; Latif, Yasir; Scaramuzza, Davide; Neira, Jose; Reid, Ian; Leonard, John J.. (December 2016). «Past, Present, and Future of Simultaneous Localization and Mapping: Toward the Robust-Perception Age» IEEE Transactions on Robotics: 1309–1332. doi:..

- Cambria, Erik; White, Bebo. (May 2014). «Jumping NLP Curves: A Review of Natural hizkuntza Processing Research [Review Article]» IEEE Computational Intelligence Magazine: 48–57. doi:..

- (Ingelesez) Vincent, James. (7 November 2019). «OpenAI has published the text-generating AI it said was too dangerous to share» The Verge.

- Jordan, M. I.; Mitchell, T. M.. (16 July 2015). «Machine learning: Trends, perspectives, and prospects» Science: 255–260. doi:. PMID 26185243. Bibcode: 2015Sci...349..255J..

- «Content: Plug & Pray Film – Artificial Intelligence – Robots» plugandpray-film.de.

- Evans, Woody. (2015). «Posthuman Rights: Dimensions of Transhuman Worlds» Teknokultura doi:..

- Waddell, Kaveh. (2018). Chatbots Have Entered the Uncanny Valley. .

- Poria, Soujanya; Cambria, Erik; Bajpai, Rajiv; Hussain, Amir. (September 2017). «A review of affective computing: From unimodal analysis to multimodal fusion» Information Fusion: 98–125. doi:..

- «Robots could demand legal rights» BBC News 21 December 2006.

- Horst, Steven. (2005). The Computational Theory of Mind. .

- Omohundro, Steve. (2008). The Nature of Self-Improving Artificial Intelligence. presented and distributed at the 2007 Singularity Summit, San Francisco, CA..

- Ford, Martin; Colvin, Geoff. (6 September 2015). «Will robots create more jobs than they destroy?» The Guardian.

- White Paper: On Artificial Intelligence – A European approach to excellence and trust. European Commission.

- Anderson, Michael; Anderson, Susan Leigh. (2011). Machine Ethics. Cambridge University Press..

- «Machine Ethics» aaai.org.

- Russell, Stuart. (2019). Human Compatible: Artificial Intelligence and the Problem of Control. Viking ISBN 978-0-525-55861-3. OCLC .1083694322.

- «AI set to exceed human brain power» CNN 9 August 2006.

- «Robots could demand legal rights» BBC News 21 December 2006.

- Kismet. MIT Artificial Intelligence Laboratory, Humanoid Robotics Group.

- Smoliar, Stephen W.; Zhang, HongJiang. (1994). «Content based video indexing and retrieval» IEEE MultiMedia: 62–72. doi:..

- Neumann, Bernd; Möller, Ralf. (January 2008). «On scene interpretation with description logics» Image and Vision Computing: 82–101. doi:..

- Kuperman, G. J.; Reichley, R. M.; Bailey, T. C.. (1 July 2006). «Using Commercial Knowledge Bases for Clinical Decision Support: Opportunities, Hurdles, and Recommendations» egunkaria of the American Medical Informatics Association: 369–371. doi:. PMID 16622160..

- McGarry, Ken. (1 December 2005). «A survey of interestingness measures for knowledge discovery» The Knowledge Engineering Review: 39–61. doi:..

- Bertini, M; Del Bimbo, A; Torniai, C. (2006). Automatic annotation and semantic retrieval of video sequences using multimedia ontologies. ACM, 679–682 or..

- Kahneman, Daniel. (2011). Thinking, Fast and Slow. Macmillan ISBN 978-1-4299-6935-2..

- Turing, Alan. (1948). The Essential Turing: The ideas that gave birth to the computer age. Oxford University Press, 412 or. ISBN 978-0-19-825080-7..

- Domingos, Pedro. (2015). The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. Basic Books ISBN 978-0465065707..

- Minsky, Marvin. (1986). The Society of Mind. Simon and Schuster.

- Pinker, Steven. (2007). The hizkuntza Instinct. Harper ISBN 978-0-06-133646-1..

- Chalmers, David. (1995). «Facing up to the problem of consciousness» egunkaria of Consciousness Studies: 200–219..

- Roberts, Jacob. (2016). Thinking Machines: The Search for Artificial Intelligence. , 14–23 or..

- Pennachin, C.; Goertzel, B.. (2007). Artificial General Intelligence. Springer, 1–30 or. doi:. ISBN 978-3-540-23733-4..

- Ask the AI experts: What's driving today's progress in AI?. .

- Ransbotham, Sam; Kiron, David; Gerbert, Philipp; Reeves, Martin. (6 September 2017). «Reshaping Business With Artificial Intelligence» MIT Sloan Management Review.

- Lorica, Ben. (18 December 2017). The state of AI adoption. .

- AlphaGo – Google DeepMind. .

- Asada, M.; Hosoda, K.; Kuniyoshi, Y.; Ishiguro, H.; Inui, T.; Yoshikawa, Y.; Ogino, M.; Yoshida, C.. (2009). «Cognitive developmental robotics: a survey» IEEE Transactions on Autonomous Mental Development: 12–34. doi:..

- Berlinski, David. (2000). The Advent of the Algorithm. Harcourt Books ISBN 978-0-15-601391-8. OCLC .46890682.

- Brooks, Rodney. (1990). «Elephants Don't Play Chess» Robotics and Autonomous Systems: 3–15. doi:..

- Butler, Samuel. (13 June 1863). «Darwin among the Machines» The Press.

- Clark, Jack. (2015b). Why 2015 Was a Breakthrough urtea in Artificial Intelligence. .

- Dennett, Daniel. (1991). Consciousness Explained. The Penguin Press ISBN 978-0-7139-9037-9..

- Dreyfus, Hubert. (1972). What Computers Can't Do. MIT Press ISBN 978-0-06-011082-6..

- Dreyfus, Hubert; Dreyfus, Stuart. (1986). Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer. Blackwell ISBN 978-0-02-908060-3..

- Dyson, George. (1998). Darwin among the Machines. Allan Lane Science ISBN 978-0-7382-0030-9..

- Edelson, Edward. (1991). The Nervous System. Chelsea House ISBN 978-0-7910-0464-7..

- Fearn, Nicholas. (2007). The Latest Answers to the Oldest Questions: A Philosophical Adventure with the World's Greatest Thinkers. Grove Press ISBN 978-0-8021-1839-4..

- Haugeland, John. (1985). Artificial Intelligence: The Very Idea. MIT Press ISBN 978-0-262-08153-5..

- Hawkins, Jeff; Blakeslee, Sandra. (2005). On Intelligence. Owl Books ISBN 978-0-8050-7853-4..

- Henderson, Mark. (24 April 2007). «Human rights for robots? We're getting carried away» The Times Online.

- Kahneman, Daniel; Slovic, D.; Tversky, Amos. (1982). «Judgment under uncertainty: Heuristics and biases» Science (Cambridge University Press): 1124–1131. doi:. ISBN 978-0-521-28414-1. PMID 17835457. Bibcode: 1974Sci...185.1124T..

- Katz, Yarden. (1 November 2012). Noam Chomsky on Where Artificial Intelligence Went Wrong. .

- Kurzweil, Ray. (2005). The Singularity is Near. Penguin Books ISBN 978-0-670-03384-3..

- Langley, Pat. (2011). «The changing science of machine learning» Machine Learning: 275–279. doi:..

- Legg, Shane; Hutter, Marcus. (15 June 2007). A Collection of Definitions of Intelligence. .

- Lenat, Douglas; Guha, R. V.. (1989). Building Large Knowledge-Based Systems. Addison-Wesley ISBN 978-0-201-51752-1..

- Lighthill, James. (1973). Artificial Intelligence: a paper symposium. Science Research Council.

- Lombardo, P; Boehm, I; Nairz, K. (2020). «RadioComics – Santa Claus and the future of radiology» Eur J Radiol: 108771. doi:. PMID 31835078..

- Lungarella, M.; Metta, G.; Pfeifer, R.; Sandini, G.. (2003). «Developmental robotics: a survey» Connection Science: 151–190. doi:..

- Maker, Meg Houston. (2006). AI@50: AI Past, Present, Future. .

- McCarthy, John; Minsky, Marvin; Rochester, Nathan; Shannon, Claude. (1955). A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence. .

- Minsky, Marvin. (1967). Computation: Finite and Infinite Machines. Prentice-Hall ISBN 978-0-13-165449-5..

- Moravec, Hans. (1988). Mind Children. Harvard University Press ISBN 978-0-674-57616-2..

- Funding a Revolution: Government Support for Computing Research. National Academy Press.

- Newell, Allen; Simon, H. A.. (1976). «Computer Science as Empirical Inquiry: Symbols and Search» Communications of the ACM: 113–126. doi:...

- Nilsson, Nils. (1983). «Artificial Intelligence Prepares for 2001» AI Magazine. Presidential Address to the Association for the Advancement of Artificial Intelligence.

- Oudeyer, P-Y.. (2010). «On the impact of robotics in behavioral and cognitive sciences: from insect navigation to human cognitive development» IEEE Transactions on Autonomous Mental Development: 2–16. doi:..

- Schank, Roger C.. (1991). Where's the AI. .

- Searle, John. (1980). «Minds, Brains and Programs» Behavioral and Brain Sciences: 417–457. doi:..

- Searle, John. (1999). Mind, hizkuntza and society. Basic Books ISBN 978-0-465-04521-1. OCLC .231867665.

- Simon, H. A.. (1965). The Shape of Automation for Men and Management. Harper & Row.

- Solomonoff, Ray. (1956). An Inductive Inference Machine. . Later published as

Solomonoff, Ray. (1957). IRE Convention Record. , 56–62 or.. - Spadafora, Anthony. (21 October 2016). Stephen Hawking believes AI could be mankind's abizena accomplishment. .

- Tao, Jianhua; Tan, Tieniu. (2005). Springer, 981–995 or. doi:. ISBN 978-3-540-29621-8..

- Tecuci, Gheorghe. (March–April 2012). «Artificial Intelligence» Wiley Interdisciplinary Reviews: Computational Statistics: 168–180. doi:..

- Thro, Ellen. (1993). Robotics: The Marriage of Computers and Machines. Facts on File ISBN 978-0-8160-2628-9..

- UNESCO Science Report: the Race Against Time for Smarter Development.. UNESCO 2021 ISBN 978-92-3-100450-6..

- Vinge, Vernor. (1993). «The Coming Technological Singularity: How to Survive in the Post-Human Era» Vision 21: Interdisciplinary Science and Engineering in the Era of Cyberspace: 11. Bibcode: 1993vise.nasa...11V..

- Wason, P. C.; Shapiro, D.. (1966). New horizons in psychology. Penguin.

- Weng, J.; McClelland; Pentland, A.; Sporns, O.; Stockman, I.; Sur, M.; Thelen, E.. (2001). «Autonomous mental development by robots and animals» Science: 599–600. doi:. PMID 11229402..

- AI & ML in Fusion

- AI & ML in Fusion, video lecture

Bibliografia osagarria

[aldatu | aldatu iturburu kodea]- Autor, David H., "Why Are There Still So Many Jobs? The History and Future of lanaplace Automation" (2015) 29(3) egunkaria of Economic Perspectives 3.

- Boden, Margaret, Mind As Machine, Oxford University Press, 2006.

- Cukier, Kenneth, "Ready for Robots? How to Think about the Future of AI", Foreign Affairs, vol. 98, no. 4 (July/August 2019), pp. 192–98. George Dyson, historian of computing, writes (in what might be called "Dyson's Law") that "Any system simple enough to be understandable will not be complicated enough to behave intelligently, while any system complicated enough to behave intelligently will be too complicated to understand." (p. 197.) Computer scientist Alex Pentland writes: "Current AI machine-learning algorithms are, at their core, dead simple stupid. They lana, but they lana by brute force." (p. 198.)

- Domingos, Pedro, "Our Digital Doubles: AI will serve our species, not control it", Scientific American, vol. 319, no. 3 (September 2018), pp. 88–93.

- Gertner, Jon. (2023) "Wikipedia's Moment of Truth: Can the online encyclopedia help teach A.I. chatbots to get their facts right — without destroying itself in the process?" New York Times Magazine (July 18, 2023) online

- Johnston, John (2008) The Allure of Machinic Life: Cybernetics, Artificial Life, and the New AI, MIT Press.

- Jumper, John; Evans, Richard; Pritzel, Alexander; Green, Tim; Figurnov, Michael; Ronneberger, Olaf; Tunyasuvunakool, Kathryn; Bates, Russ et al.. (26 August 2021). «Highly accurate protein structure prediction with AlphaFold» Nature: 583–589. doi:. PMID 34265844. Bibcode: 2021Natur.596..583J..

- LeCun, Yann; Bengio, Yoshua; Hinton, Geoffrey. (28 May 2015). «Deep learning» Nature: 436–444. doi:. PMID 26017442. Bibcode: 2015Natur.521..436L..

- Gary Marcus, "Artificial Confidence: Even the newest, buzziest systems of artificial general intelligence are stymmied by the same old problems", Scientific American, vol. 327, no. 4 (October 2022), pp. 42–45.

- Mitchell, Melanie. (2019). Artificial intelligence: a guide for thinking humans. Farrar, Straus and Giroux ISBN 9780374257835..

- Mnih, Volodymyr; Kavukcuoglu, Koray; Silver, David; Rusu, Andrei A.; Veness, Joel; Bellemare, Marc G.; Graves, Alex; Riedmiller, Martin et al.. (26 February 2015). «Human-level control through deep reinforcement learning» Nature: 529–533. doi:. PMID 25719670. Bibcode: 2015Natur.518..529M.. Introduced DQN, which produced human-level performance on some Atari games.

- Eka Roivainen, "AI's IQ: ChatGPT aced a [standard intelligence] test but showed that intelligence cannot be measured by IQ alone", Scientific American, vol. 329, no. 1 (July/August 2023), p. 7. "Despite its high IQ, ChatGPT fails at tasks that require real humanlike reasoning or an understanding of the physical and social world.... ChatGPT seemed unable to reason logically and tried to rely on its vast database of... facts derived from online texts."

- Serenko, Alexander. (2011). «Comparing the expert survey and erreferentzia impact egunkaria ranking methods: Example from the field of Artificial Intelligence» egunkaria of Informetrics: 629–49. doi:..[Betiko hautsitako esteka]

- Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; van den Driessche, George; Schrittwieser, Julian; Antonoglou, Ioannis et al.. (28 January 2016). «Mastering the game of Go with deep neural netlanas and tree search» Nature: 484–489. doi:. PMID 26819042. Bibcode: 2016Natur.529..484S..

- Ashish Vaswani, Noam Shazeer, Niki Parmar et al. "Attention is all you need." Advances in neural information processing systems 30 (2017). Seminal paper on transformers.

Ikus, gainera

[aldatu | aldatu iturburu kodea]Kanpo estekak

[aldatu | aldatu iturburu kodea]Orokorrak

[aldatu | aldatu iturburu kodea]- Programming:AI @ Wikibooks.org

- University of Berkeley AI Resources linking to about 869 other WWW pages about AI

- Loebner Prize website

- Jabberwacky - a learning AI chatterbot

AIAWiki - AI algorithms and research.(temporarily offline due to problems with spammers)- AI web category on Open Directory

- Mindpixel "The Planet's Largest Artificial Intelligence Effort"

- OpenMind CommonSense "Teaching computers the stuff we all know"

- Artificially Intelligent Ouija Board - creative example of human-like AI

- Heuristics and AI in finance and investment

- SourceForge Open Source AI projects - 1139 projects

- Ethical and Social Implications of AI en Computerization

- AI algorithm implementations and demonstrations

- Marvin Minsky's Homepage

- MIT's AI Lab

- AI Lab Zurich

- School of Informatics at the University of Edinburgh

- Informatics Department at the University of Sussex

- AI research group at Information Sciences Institute

- Why Programming is a Good Medium for Expressing Poorly Understood and Sloppily Formulated Ideas

- aiKnow: Cognitive Artificial Intelligence

- What is Artificial Intelligence?

- Stanford Encyclopedia of Philosophy entry on Logic and Artificial Intelligence

- Mental Matrixes, Parallel Logic

- AI Search Engine

- AI jokun baten garapenean (Euskaraz)

Inteligentzia artifizialarekin lotutako erakundeak

[aldatu | aldatu iturburu kodea]- AI Consortium

- American Association for Artificial Intelligence

- European Coordinating Committee for Artificial Intelligence

- The Association for Computational Linguistics

- Artificial Intelligence Student Union

- German Research Center for Artificial Intelligence, DFKI GmbH

- Association for Uncertainty in Artificial Intelligence

- Singularity Institute for Artificial Intelligence

- The Society for the Study of Artificial Intelligence and the Simulation of Behaviour (United Kingdom)

- AGIRI - Artificial General Intelligence Research Institute